vmware esxi 做链路聚合LACP踩坑

一、项目背景

客户有1台dell服务器,服务器上有4个千兆业务口,通过esxi进行虚拟化,客户现在希望将服务器的3个端口进行链路聚合,使整个服务器的出口带宽从1G提升到3G。想想自己对交换机的链路聚合还是比较清楚地,发现链路聚合以后,虚拟机之间丢包非常严重,甚至不通。客户现在用的是v6.7u1版本,查阅资料后发现有坑。

二、技术资料

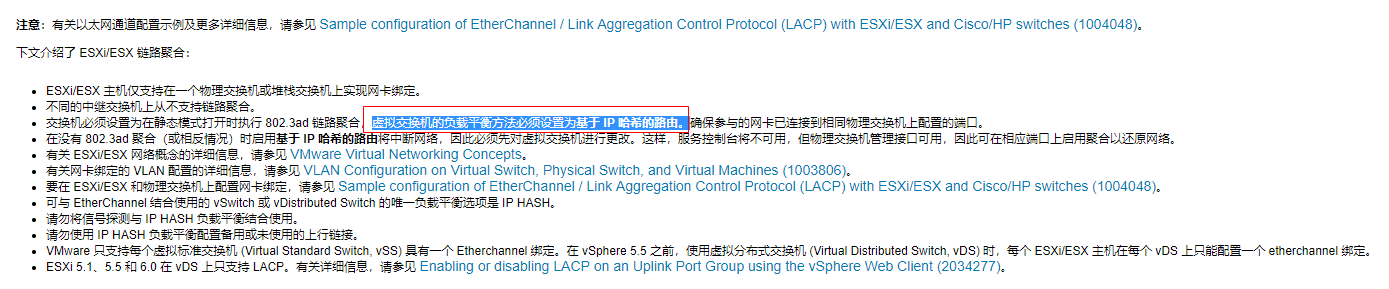

通过百度和谷歌,找到到esxi的官方资料。https://kb.vmware.com/articleview?docid=1001938&lang=zh_CN,其只支持静态聚合下的基于IP哈希的流量分布算法。

PS:

- 请勿将信号探测与 IP HASH 负载平衡结合使用。

- 请勿使用 IP HASH 负载平衡配置备用或未使用的上行链接。

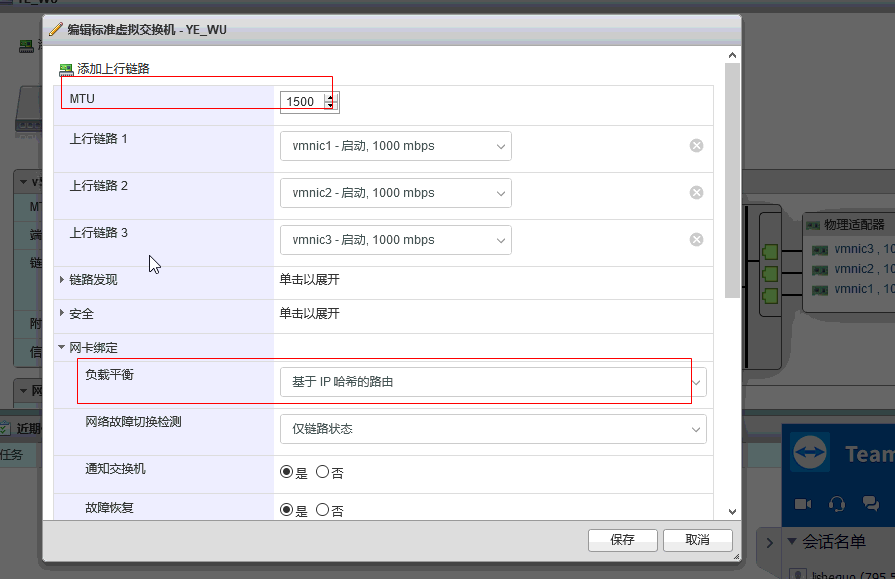

虚拟交换机的负载平衡方法必须设置为基于 IP 哈希的路由

三、交换机配置方法

华三交换机

system-view

interface bridge-aggregation 1 #建立静态二层聚合端口1

quit

interface interface-type g1/0/1 #接入物理接口1/0/1

port link-aggregation group number #将物理接口加入到聚合端口1

interface bridge-aggregation 1 #进入二层聚合端口1

link-aggregation load-sharing mode destination-ip source-ip #基于源IP和目的IP进行负载分担

华为交换机

system-view,#进入系统视图。

interface eth-trunk 1,#进入Eth-Trunk 1 接口视图。

mode manual load-balance ,#配置Eth-Trunk的工作模式。缺省情况下,Eth-Trunk的工作模式为手工模式。

trunkport gigabitethernet 0/0/1 to 0/0/3 #交换机1到3口加入到聚合组1

interface eth-trunk 1,#进入Eth-Trunk 1 接口视图。

load-balance src-dst-ip #配置Eth-Trunk负载分担方式。缺省情况下,交换机上Eth-Trunk接口的负载分担模式为src-dst-ip。

锐捷交换机

enable #进入特权模式

configure terminal #进入配置模式

interface range gigabitEthernet 0/1-2 #同时进入到g0/1-2口配置模式

port-group 1 #添加到AG1聚合端口

exit #退出当前模式

interface aggregateport 1 #进入AG1口配置模式

aggregateport load-balance src-dst-ip #更改流量平衡算法为源目ip模式,默认为源MAC+目的MAC模式

exit #退出当前模式

wr #保存

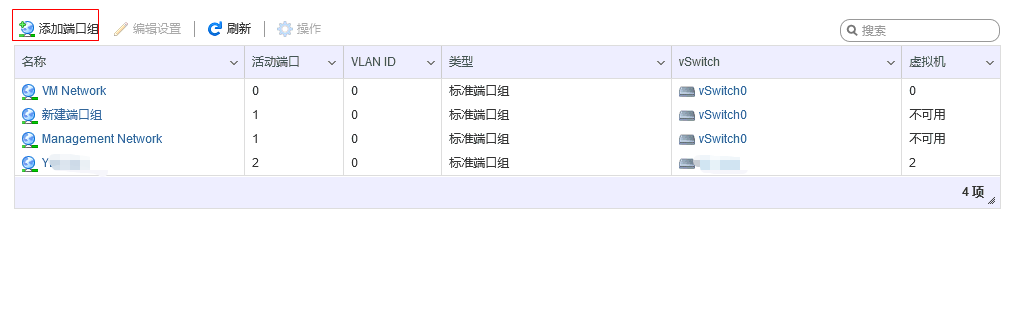

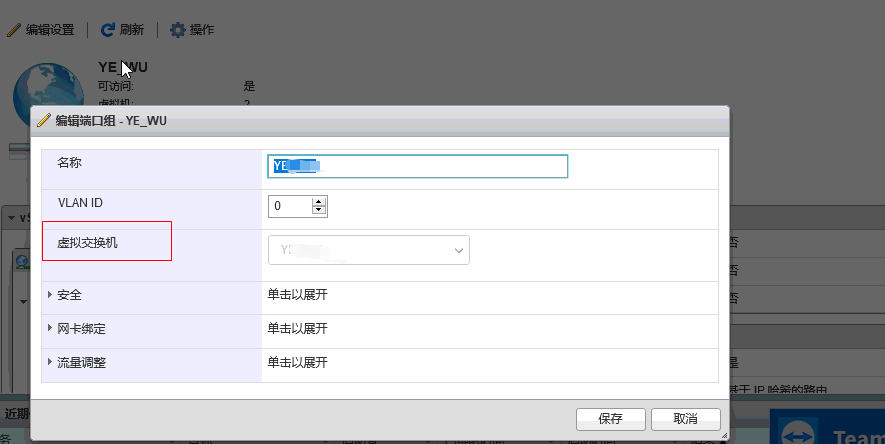

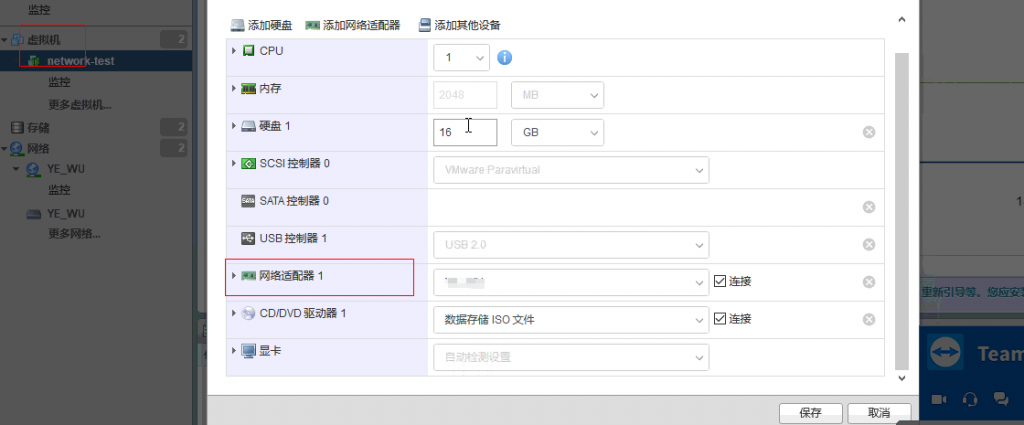

四、esxi链路聚合配置方式